Das Framework eines Sicherheitspraktikers für KI-Sicherheit und Schutz

Anfang November war Großbritannien Gastgeber des AI Safety Summit, des ersten globalen Gipfels zum Thema Künstliche Intelligenz. Sie brachte internationale Regierungen und KI-Experten zusammen, um über die Risiken von KI nachzudenken und darüber, wie international koordinierte Bemühungen dazu beitragen können, diese zu mindern. Dieser Gipfel folgt den weltweiten Diskussionen über die Sicherheit von KI, einschließlich der jüngsten US-amerikanischen Durchführungsverordnung über die sichere und vertrauenswürdige Entwicklung und Nutzung von KI.

Ich hatte erwartet, dass aus dem Gipfel ein spezifischer Rahmen oder Richtlinien für die KI-Sicherheit hervorgehen würden – aber ich war enttäuscht, dass ich keine greifbaren Leitlinien fand. In diesem Blogbeitrag habe ich die Art von umsetzbarem Framework für KI-Sicherheit skizziert, von dem ich mir aus meiner Sicht als leitender Sicherheitsexperte von dem Gipfel erhofft hatte.

Nutzen Sie die Neuheit der KI, um die Sicherheit zu gewährleisten

Bevor ich den Rahmen darlege, ist es meiner Meinung nach wichtig, einen philosophischen Schritt zurückzutreten, um zu verstehen, warum KI-Sicherheit ein so wichtiges Thema ist und warum ich von den Ergebnissen des diesjährigen AI Safety Summit so enttäuscht war.

Es liegt auf der Hand, dass die meisten Sicherheitsmängel in den aktuellen Netzwerktechnologien, die wir heute verwenden, letztlich auf Schwächen in der Art und Weise zurückzuführen sind, wie die Protokolle, von denen sie abhängen, ursprünglich vor Jahrzehnten entwickelt wurden.

Sicherheit war keine anfängliche Überlegung. In Wirklichkeit ist das selten der Fall.

Nehmen Sie zum Beispiel die ursprünglichen Protokolle für Web (HTTP), Mail (SMTP) und Dateiübertragung (FTP). Diese wurden alle als Klartext ohne jegliche Form von Datensicherheit durch Verschlüsselung konzipiert. Die damaligen Entwickler sahen keine Welt vor Augen, in der Bankgeschäfte, klinische Patienteninformationen oder sensible Benutzerinformationen über diese einfachen Netzwerkprotokolle frei und bequem über den ganzen Globus übertragen werden würden.

Das Gleiche gilt für das IPv4-Adressierungsschema, das in den frühen 1980er Jahren entwickelt wurde und in der IETF-Veröffentlichung RFC 791 (Internet Engineering Task Force) beschrieben wird. Wer hätte damals gedacht, dass der Welt realistischerweise Milliarden von öffentlich adressierbaren IP-Adressen ausgehen könnten? Trotzdem erweist sich der Versuch, die Sicherheit nachträglich zu verbessern, in der Regel sowohl als Engpass als auch als störendes Unterfangen.

Generative KI wie ChatGPT von OpenAI – das diesen Monat sein erstes Jubiläum der öffentlichen Verfügbarkeit feiert – hat die Fortschritte beim maschinellen Lernen und bei Deep-Learning-Fähigkeiten gezeigt. Diese Art von großem Sprachmodell (LLM) kann die neuronalen Netzwerke des menschlichen Gehirns mithilfe von Künstlichen Neuronalen Netzen (KNN) weitgehend nachahmen. Zum ersten Mal hat die Welt im Laufe der Jahre den Höhepunkt verschiedener Arbeiten erlebt, die darauf abzielten, KI in Angeboten wie ChatGPT leicht nutzbar zu machen. Plötzlich ist selbst die Möglichkeit der Artificial General Intelligence (AGI) und der theoretisch weit überlegenen Artificial Super Intelligence (ASI) vielleicht keine Übertreibung der Fiction-Titel mehr.

Wir müssen uns die Tatsache zunutze machen, dass die KI noch früh genug in ihrer Entwicklung ist, um ihre Sicherheit zu berücksichtigen, insbesondere angesichts der Geschichte und des Gepäcks von Netzwerken und Sicherheit. Ein KI-Sicherheitsgipfel wie der im November 2023 hätte nicht nur Ängste ausräumen, sondern auch einen Schritt zurücktreten sollen, um die KI-Sicherheit anhand einer ganzheitlichen Betrachtung zu bewerten. Leider bin ich mir nicht sicher, ob dies erreicht wurde; Zumindest nicht dieses Mal.

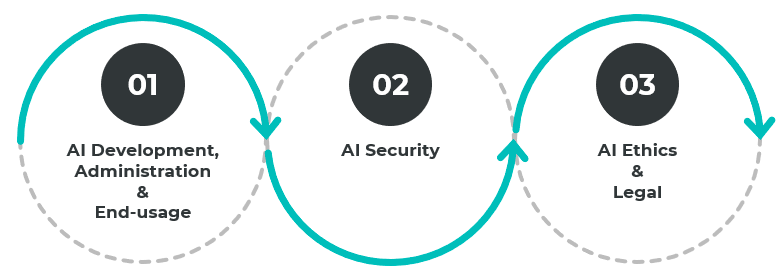

3 Hauptbereiche für KI-Sicherheit

Für den ersten proaktiven internationalen Gipfel zum Thema KI-Sicherheit habe ich einen spürbaren Übergang von der Geopolitik zur Geopolitik erwartet, um die folgenden Hauptbereiche anzusprechen:

- Entwicklung, Verwaltung und Endnutzung

- Sicherheit

- Ethik und Recht

Diese Domänen sind miteinander verflochten und daher miteinander verknüpft. So sollte beispielsweise die Entwicklung von KI-Lösungen die Bereiche Ethik und Recht umfassen, um Quellenprobleme wie Verzerrungen in Trainingsdaten und die Konfiguration versteckter Schichten von Deep-Learning-Systemen einzudämmen. Nicht alles, was funktioniert, ist auch das Richtige. Gleichzeitig sollte die Sicherstellung der Integrität der Trainingsdaten und des Entwicklungsprozesses so früh wie möglich in den Prozess einbezogen werden.

Ein KI-Sicherheitsrahmen: Was ich mir vom KI-Sicherheitsgipfel erhofft habe

Für jeden der drei Bereiche habe ich eine Auswahl von Schlüsselstandards und -frameworks vorgeschlagen, die weiter in Betracht gezogen werden sollten, deren Endergebnis die Initiierung von fokussierten Gruppen sein sollte, die sich mit der Formulierung dieser Standards und Frameworks befassen:

Entwicklung, Verwaltung und Endnutzung

- Schnittstellen zu Standards und Rahmenwerken: Richtlinien und Standards für die Schnittstelle von KI zwischen verschiedenen Anbietern und dann zwischen Anbietern und Endbenutzern, ähnlich wie bei der Web-API mit JSON und USB-C für physische Geräte. Dies kann eine noch schnellere Innovation über mehrere Domänen hinweg ermöglichen. Ein gutes Beispiel dafür ist die Vernetzung von Wi-Fi und mobiler Kommunikation für die technologische Innovation bei Smartwatches, Fernsehern, Drohnen, Autos, Krankenwagen usw.

- Differenzierungsstandards und Rahmenwerk: Richtlinien, die eine klare Bestimmung und Unterscheidung zwischen originären künstlerischen Werken und KI-generierten Werken ermöglichen, wie wir sie für das Digital Rights Management (DRM), das Urheberrecht und den Schutz geistigen Eigentums haben. Ein wichtiger Bereich der Nutznießer wird die Bekämpfung von Fehlinformationen und irreführenden Inhalten wie Deep Fakes und Wahlbeeinflussung sein, zumindest auf der Ebene der Rohstoffe.

- KI-Kompetenzlücke: Behebung der Qualifikationslücke in den Schlüsselbereichen KI-Entwicklung, KI-Verwaltung und KI-Nutzung, ähnlich wie die Bemühungen in der Computerprogrammierung und Computerkompetenz (einschließlich Erwachsenenbildung) während des frühen Booms des Personal Computing bis heute. Dies soll die Wettbewerbsbedingungen sowohl für die Entwicklung und den Einsatz von guter als auch für schlechte Werbe-KI ausgleichen.

Sicherheit

- Singularität des Formularschutzes: Richtlinien und Schutzmaßnahmen für die Verschmelzung von KI (wie ChatGPT, Sprach-KI, Bilderkennungs-KI usw.) mit tatsächlicher Hardware in einer einzigen Form, ähnlich wie bei Industrierobotern oder humanoiden Robotern in der Zukunft. Eine solche Fähigkeit verleiht der KI der allgemeinen Intelligenz letztlich physische Interaktionsmöglichkeiten in der physischen Welt. Im Grunde geht es darum, sicherzustellen, dass sich ein physischer Roboter vom Typ ChatGPT niemals gegen Menschen wendet oder auf katastrophale Weise eine Fehlfunktion erleidet. Es gibt bereits verschiedene Fälle, in denen Industrieroboter und selbstfahrende Autos Fehlfunktionen aufweisen und Menschen zu Schaden oder Tod geführt haben.

- Risiko durch KI: Schutz vor Risiken, die von KI ausgehen. ChatGPT hat bereits eine böswillige Nutzung gezeigt. In diesem Bereich werden Bedrohungen wie sich entwickelnde bösartige Payloads, die Entdeckung und Ausnutzung von Schwachstellen in Rekordgeschwindigkeit, Sprach- und Phishing-Betrug sowie Sabotage wie die Kompromittierung von Fertigungsprozessen oder Angriffe auf die Lieferkette berücksichtigt.

- Risiko für die KI: Schutz vor Risiken, die für die KI selbst bestehen. Dazu gehört die Ausnutzung von KI-Entwicklung, Lernprozessen und Bias-Parametern. Es gibt zwar Richtlinien für die Ethik, Sicherheit und Nutzung von KIs, aber sie müssen verbessert werden und die aktuellen Sicherheitspraktiken wie sichere Codierung, DevSecOps und SBOMS in der Lieferkette verbessern. Abgesehen von der Verbrauchsseite haben wir Richtlinien, die dem Computer Misuse Act, den Sicherheitsrichtlinien von Unternehmen zur Computernutzung und den Richtlinien zur fairen Nutzung ähneln.

Ethik und Recht

- KI-Bürgerethik: Ethik und Richtlinien für den Einsatz von KI in Bereichen wie Gesichtserkennung und Nutzerverhalten gegen Mitarbeiterüberwachung, Verkehrskontrolle und -durchsetzung sowie das Strafrechtssystem.

- Wissenschaftliche Ethik der KI: Ethik und Richtlinien, wozu KI in Bezug auf Wissenschaft und Medizin eingesetzt werden kann. Beispiele sind Gen- und Krankheitsforschung, Klonen usw.

- KI-Militärethik: Entwicklung eines Satzes von Einsatzregeln nach dem Vorbild der Genfer Konvention für den Einsatz von KI in kinetischen Operationen, insbesondere in der autonomen KI. Dies wäre besonders wichtig, wenn KI Entscheidungen über Leben und Tod trifft, um die Möglichkeit unbeabsichtigter Folgen wie Massenmord, Einsatz chemischer Waffen oder einer unbeabsichtigten nuklearen Explosion zu verhindern.

- KI-Rechtsrahmen: Richtlinien und Standards rund um die rechtlichen Auswirkungen der Einbeziehung von KI in verschiedenen rechtlich relevanten Situationen. Dazu gehören Szenarien wie die Art der zulässigen Beweismittel in Rechtssachen oder Versicherungs- und Finanzschäden sowie Risikoakzeptanzberechnungen.

Ein KI-Sicherheits-Framework ist nur der Anfang

Es ist ermutigend zu sehen, dass das Risiko von KI-Cyberbedrohungen auf globaler Ebene stark in den Fokus gerückt wird. Ein KI-Sicherheitsrahmen ist ein wesentlicher erster Schritt zum Aufbau einer innovativen und dennoch sicheren KI-Zukunft. Aber das ist nur ein Anfang. Im Idealfall sollte es eine Auswahl von elitären, fokussierten Gruppen von KI- und Branchenexperten geben, die zusammenarbeiten, um KI-Sicherheitsstandards zu entwickeln und zu iterieren, ähnlich wie die Internet Engineering Task Force (IETF) und Request for Comments (RFCs).

Wichtig ist, dass wir auch darüber nachdenken, wie wir Unternehmen in die Lage versetzen können, ihre Widerstandsfähigkeit gegen KI-gestützte Angriffe zu stärken. KI macht es für Kriminelle einfacher und schneller, Angriffe zu starten. Die beste Verteidigung besteht darin, die "Lernfläche" zu verkleinern, so dass KI-Cyberbedrohungen weniger Möglichkeiten haben, den Angriff zu lernen, sich anzupassen und voranzutreiben.

Kontaktieren Sie uns noch heute , um zu erfahren, wie sich Entwicklungen im Bereich KI auf die Cybersicherheit Ihres Unternehmens auswirken können.

.png)

.webp)

_(2).webp)

.webp)

.webp)