Die Geschichte – und die Herausforderungen – von Firewalls der nächsten Generation

Vor etwa sechzehn Jahren, im Jahr 2007, stellte Palo Alto Networks sein erstes Produkt vor, das die Netzwerksicherheit für immer veränderte. Der Begriff "Next-Generation Firewall" (NGFW) war noch nicht geprägt. Das passierte, als Gartner den Begriff im Jahr 2009 einführte. Zu dieser Zeit fielen die Produkte von Palo Alto unter den früheren Begriff "Unified Thread Management" (UTM). Palo Alto hat zwar weder die UTM noch die NGFW erfunden, aber sie sind seitdem das bestimmende Produkt in diesem Bereich, an dem sich alle Wettbewerber messen lassen. Für die Zwecke dieses Beitrags werden wir der Einfachheit halber nur den Spitznamen NGFW verwenden.

Während das, was wir heute "die Cloud" nennen, im Jahr 2007 tatsächlich existierte, wurden Rechenzentren immer noch weitgehend auf traditionelle Weise gebaut: eine harte, knusprige Sicherheitshülle um ein weiches, klebriges Zentrum aus Daten und Rechenleistung. Nur die mutigsten Unternehmen verlagerten Assets in AWS (Amazon Web Services) und andere neue Cloud-Services. Das Rechenzentrum hatte noch eine definierte und bekannte Grenze. Die Grenzen zwischen den Assets innerhalb des Rechenzentrums und denen außerhalb waren klar.

NGFWs: Perfekt zum Schutz des Rechenzentrumsumfangs

Die NGFW mit ihrer Vielzahl leistungsstarker Sicherheitsfunktionen passte wunderbar zu diesem Modell. NGFWs wurden schnell zu den Gatekeepern von Rechenzentren und kontrollierten sorgfältig, was in einem bestimmten Netzwerk einging (und in weitaus geringerem Maße, was wieder herauskam). Leistungsstarke benutzerdefinierte CPUs analysierten und verschoben Pakete schnell auf ihrem Weg, und die für die Sicherheit verantwortlichen Personen schliefen nachts ein wenig besser, da sie wussten, dass ihre Ressourcen durch eine Reihe neuer Tools geschützt waren.

NGFW-Anbieter wie Palo Alto Networks, Check Point und Fortinet setzten sich nun ein neues Ziel: die Dominanz im Rechenzentrum, die Überwachung und Steuerung des Datenverkehrs zwischen Anwendungen, da die Netzwerksegmentierung als das "heiße neue Ding" in Mode kam.

Hier standen sie jedoch vor einer weitaus größeren Herausforderung. NGFWs waren eine naheliegende Wahl, um den Umfang des Rechenzentrums zu schützen. Die unerschwinglichen Kosten für Hardware, Lizenzierung und Support wurden durch die klaren Vorteile gerechtfertigt, und der Preis wurde durch die Tatsache in Grenzen gehalten, dass die Internetverbindungen zu den Rechenzentren im Vergleich zur internen Konnektivität relativ langsam waren und der Preis mit der Bandbreite steigt. Im Inneren war ein so eindeutiges Kosten-Nutzen-Verhältnis bei weitem nicht zu finden. Ein erheblicher Prozentsatz der NGFW-Funktionen, nehmen Sie die DDoS-Abwehr oder das Traffic-Shaping als Beispiele, hatte im Inneren keinen Wert. Aber Sie haben trotzdem dafür bezahlt.

Als ob die horrenden Kosten für den 10G-Durchsatz nicht schon abschreckend genug für den internen Gebrauch wären, wurden alle Kosten um der Redundanz willen verdoppelt. Es war extrem schwierig, das Fünffache der Ausgaben einer herkömmlichen Firewall für eine Reihe von Funktionen zu rechtfertigen, die übertrieben und oft nicht relevant für die anstehende Aufgabe waren.

Allerdings erfordern industrielle und staatliche Vorschriften bestimmte Kontrollen im Inneren, zumindest für bestimmte Anwendungsklassen. HIPPA und PCI kommen mir als herausragende Beispiele in den Sinn. Daher entschieden sich die Kunden für hybride Lösungen, bei denen NGFW-Geräte die Grenze und einige kritische, spezifische Anwendungen schützten, wobei herkömmliche zustandsbehaftete Nicht-NGFWs die Lücke des internen Schutzes füllten. Diese unglückliche Ehe von Alt und Neu funktionierte eine Zeitlang. Bis hin zur Mainstream-Akzeptanz der Public Cloud.

Management der NGFW-Komplexität in der Cloud

Die Public Cloud hat die Sicherheitswelt auf den Kopf gestellt. Aber nicht für jeden und nicht immer auf offensichtliche Weise.

Denken Sie daran, dass NGFWs bei jedem Paket, das ihr Gehäuse durchläuft, eine erstaunliche Menge an Verarbeitung durchführen. Die Intel-Architektur, so allgegenwärtig sie auch ist, ist eine schlechte Wahl für die epischen Mengen an Low-Level-Arbeit, die innerhalb einer NGFW erledigt werden muss. Palo Alto entschied sich für Cavium Network Processors, um all die Paketinspektion und -manipulation auf niedriger Ebene durchzuführen. Fortinet hat seine eigenen internen Kundenprozessoren entwickelt, um die Arbeit zu erledigen.

Der heutige NGFW ist, gemessen an den Standards von vor nur einem Jahrzehnt, ein Supercomputer der Klasse einer Regierungsbehörde, der sicherlich einen Teil der Kosten ausmacht. Die NGFW-Anbieter reagierten schnell auf den Wechsel in die Cloud mit virtuellen Versionen ihrer Produkte, aber die Leistung war aufgrund der Einschränkungen der Intel-Architektur auf der ganzen Linie miserabel.

Dies führte zu großen Veränderungen in der Art und Weise, wie die Sicherheit an der Grenze von Cloud-Netzwerken gehandhabt wurde. Oft wurden Dutzende von virtuellen Firewalls mit Lastausgleich ausgestattet. Die Netzwerkarchitektur wurde so umgestaltet, dass sie über weitaus mehr Internet-Peering-Punkte verfügen als zu Zeiten, wodurch die Leistungsanforderungen pro Firewall gesenkt wurden. Und Firewall-Anbieter begannen, ihre VM-Implementierungen (Virtual Machine) in Sechser- und Zehnerpacks zu verkaufen, weil ein oder zwei Firewalls diese Aufgabe nicht mehr erfüllen konnten.

Wenn das komplex zu erstellen und zu verwalten klingt, bedauern Sie das typischere Unternehmen, das nur einen Teil seiner Assets in die Cloud verlagert hat. Mit der zunehmenden Verbreitung von IaaS (Infrastructure-as-a-Service) und PaaS (Platform-as-a-Service) wurden die Netzwerkgrenzen immer unklarer. Während die IT-bezogene Definition von "Cloud" von der Idee abgeleitet wurde, dass eine große Anzahl von Computern (analog zu Wasserdampf) aus der Ferne als ein Computer zusammen betrachtet wird, wurde es immer passender, eine andere Definition zu verwenden: "Etwas, das verdunkelt oder verwischt".

Als Rechenzentren begannen, eine zufällige Auswahl von Anwendungen und Teilen von Anwendungen in der Cloud zu hosten, während andere Anwendungen (und Teile von Anwendungen) vor Ort verblieben, wurde es unglaublich schwierig, sie zu schützen und Sicherheitsrichtlinien durchzusetzen. Dies liegt vor allem daran, dass es fast unmöglich wurde, Grenzen zu definieren, auf die normalerweise Sicherheit angewendet wird. Und selbst in den Fällen, in denen die Grenzen klar waren, wurde die schiere Menge an Sicherheitshardware, -software und -konfiguration überwältigend.

In der Folge machte die Sicherheit einen großen Schritt zurück.

Blick in die Zukunft: NGFW-Funktionen in einer Mikrosegmentierungsumgebung

So begann der Bereich dessen, was in den Anfängen als Mikrosegmentierung bekannt war und heute häufiger als Zero Trust Segmentation (ZTS) bezeichnet wird.

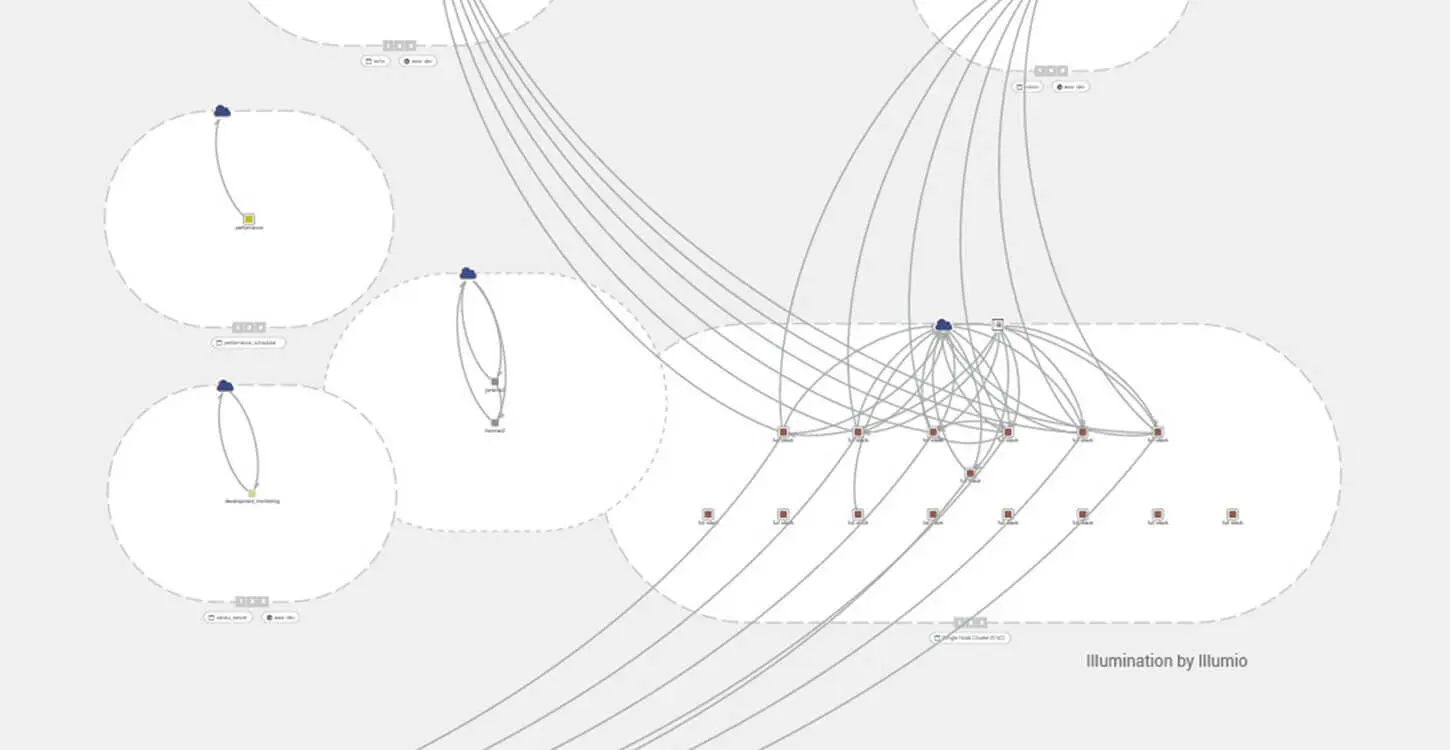

Das Konzept der Mikrosegmentierung ist einfach: Durchsetzung von Richtlinien (d. h. Firewalls) auf jedem Server, die sowohl den eingehenden als auch den ausgehenden Datenverkehr zu jedem anderen Server kontrollieren. Im Grunde genommen ist die Mikrosegmentierung einfach eine Erweiterung der Idee der Netzwerksegmentierung, die auf die Spitze getrieben wird (eine Firewall pro Server). Die Mikrosegmentierung gab Sicherheitsteams ein leistungsstarkes neues Werkzeug an die Hand, um die "unscharfen Grenzen" um und in unseren Rechenzentren zu bewältigen, indem sie die Sicherheit auf Server-für-Server-Basis (oder zumindest von Anwendung zu Anwendung) angingen.

In der Vergangenheit hat sich die Mikrosegmentierung mit Ports und Protokollen befasst, ohne in das für NGFW-Funktionen erforderliche Gebiet der Deep Inspection einzutauchen.

Im Büro des CTO ist es meine Aufgabe, "Was wäre, wenn?" zu spielen und zu versuchen, auf mögliche zukünftige Probleme und deren mögliche Lösungen zu blicken. Die aktuelle Forschung bei Illumio befasst sich daher unter anderem mit den Möglichkeiten, NGFW-Funktionen in einer Mikrosegmentierungsumgebung zu implementieren.

Lesen Sie nächste Woche meinen Blog, um mehr über die Forschung von Illumio und diese potenziellen zukünftigen Entwicklungen im Bereich der Mikrosegmentierung zu erfahren.

.png)