Un cadre pour les praticiens de la sécurité pour la sûreté et la sécurité de l'IA

Début novembre, le Royaume-Uni a accueilli l'AI Safety Summit, le tout premier sommet mondial sur l'intelligence artificielle. Elle a réuni des gouvernements internationaux et des experts en IA pour examiner les risques de l'IA et la manière dont des efforts coordonnés au niveau international peuvent contribuer à les atténuer. Ce sommet fait suite aux discussions mondiales sur la sécurité de l'IA, notamment le récent décret américain sur le développement et l'utilisation sûrs, sécurisés et dignes de confiance de l'IA.

Je m'attendais à ce que le sommet débouche sur un cadre ou des lignes directrices spécifiques en matière de sécurité de l'IA, mais j'ai été déçu de ne trouver aucune orientation concrète. Dans cet article de blog, j'ai présenté le type de cadre d'action sur la sécurité de l'IA que j'espérais voir sortir du sommet, de mon point de vue de praticien principal de la sécurité.

Tirer parti de la nouveauté de l'IA pour aborder la question de la sûreté et de la sécurité

Avant d'exposer le cadre, je pense qu'il est important de prendre un recul philosophique pour comprendre pourquoi la sécurité de l'IA est un sujet si important et pourquoi j'ai été si déçu par les résultats du sommet sur la sécurité de l'IA de cette année.

Il est évident que la plupart des lacunes en matière de sécurité dans les technologies de réseau que nous utilisons aujourd'hui sont dues à des faiblesses dans la manière dont les protocoles dont elles dépendent ont été conçus il y a plusieurs décennies.

La sécurité n'était pas une considération initiale. En réalité, c'est rarement le cas.

Prenez par exemple les protocoles originaux pour le web (HTTP), le courrier (SMTP) et le transfert de fichiers (FTP). Ils ont tous été conçus en texte brut, sans aucune forme de sécurité des données par le biais du cryptage. Les créateurs de l'époque n'avaient pas imaginé un monde où les opérations bancaires, les informations cliniques sur les patients ou les informations sensibles sur les utilisateurs seraient toutes transmises librement et commodément à travers le monde par le biais de ces simples protocoles de réseau.

Il en va de même pour le système d'adressage IPv4 créé au début des années 1980 et décrit dans la publication RFC 791 de l'IETF (Internet Engineering Task Force). Qui aurait pu penser à l'époque que le monde pourrait, de manière réaliste, manquer de milliards d'adresses IP accessibles au public ? Malgré cela, essayer d'ajouter rétrospectivement des mesures de sécurité s'avère généralement être un goulot d'étranglement et une entreprise perturbatrice.

L'IA générative telle que ChatGPT d'OpenAI - qui fête ce mois-ci le premier anniversaire de sa disponibilité publique - a mis en évidence les progrès réalisés en matière d'apprentissage automatique et de capacités d'apprentissage profond. Ce type de modèle de langage étendu (LLM) peut largement imiter les réseaux neuronaux du cerveau humain par le biais de réseaux neuronaux artificiels (ANN). Pour la première fois, le monde a assisté à l'aboutissement de divers travaux menés au fil des ans pour que l'IA devienne facilement utilisable dans des offres telles que ChatGPT. Soudain, même la possibilité d'une intelligence générale artificielle (AGI) et d'une superintelligence artificielle (ASI), théoriquement très supérieure, pourrait ne plus être une exagération de titres de fiction.

Nous devons tirer parti du fait que l'IA en est encore à un stade suffisamment précoce de son évolution pour prendre en compte sa sûreté et sa sécurité, en particulier avec l'histoire et le bagage des réseaux et de la sécurité. Un sommet sur la sécurité de l'IA comme celui de novembre 2023 aurait dû non seulement répondre aux craintes, mais aussi prendre du recul pour évaluer la sûreté et la sécurité de l'IA dans une perspective globale. Malheureusement, je ne suis pas sûr que cet objectif ait été atteint, du moins pas cette fois-ci.

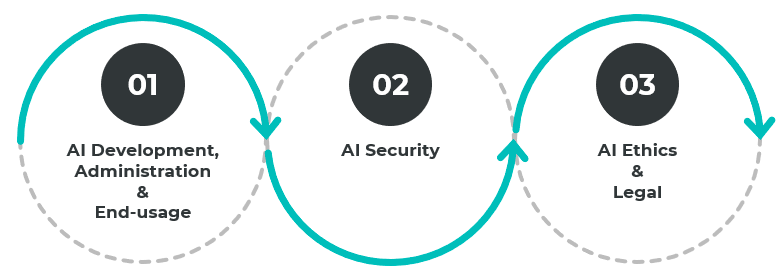

3 domaines principaux pour la sûreté et la sécurité de l'IA

Pour ce premier sommet international proactif sur la sûreté et la sécurité de l'IA, je m'attendais à ce que l'on passe concrètement de la géopolitique à la géopolitique pour aborder les principaux domaines suivants :

- Développement, administration et utilisation finale

- sécurité

- Éthique et droit

Ces domaines sont interdépendants et donc liés les uns aux autres. Par exemple, le développement de solutions d'IA devrait englober les domaines de l'éthique et du droit afin de limiter les problèmes à la source, tels que les biais dans les données d'entraînement et la configuration des couches cachées des systèmes d'apprentissage en profondeur. Tout ce qui fonctionne n'est pas forcément la bonne chose à faire. Dans le même temps, la garantie de l'intégrité des données de formation et du processus de développement devrait être incluse le plus tôt possible dans le processus.

Un cadre de sécurité pour l'IA : Ce que j'espérais voir au sommet sur la sécurité de l'IA

Pour chacun des trois domaines, j'ai suggéré une sélection de normes et de cadres clés à examiner plus avant, dont le résultat final devrait être de lancer des groupes ciblés visant à formuler ces normes et ces cadres :

Développement, administration et utilisation finale

- Normes et cadre d'interfaçage : Lignes directrices et normes sur l'interfaçage de l'IA entre différents fournisseurs, puis entre les fournisseurs et les utilisateurs finaux, similaires à l'API web avec JSON et à l'USB-C pour les dispositifs physiques. Cela peut permettre une innovation encore plus rapide dans de multiples domaines. Un bon exemple en est l'impact du Wi-Fi et de l'interface de communication mobile sur l'innovation technologique dans les montres intelligentes, les téléviseurs, les drones, les voitures, les ambulances, etc.

- Normes et cadre de différenciation : Politiques permettant de déterminer clairement et de différencier les œuvres artistiques originales des œuvres générées par l'IA, comme c'est le cas pour les droits d'auteur et les protections de la propriété intellectuelle dans le cadre de la gestion des droits numériques (DRM). L'un des principaux domaines bénéficiaires sera la lutte contre la désinformation et les contenus trompeurs, tels que les "deep fakes" et l'ingérence dans les élections, au moins au niveau des produits de base.

- Le déficit de compétences en matière d'IA : Combler le déficit de compétences dans les domaines clés du développement, de l'administration et de l'utilisation de l'IA, à l'instar des efforts déployés dans le domaine de la programmation informatique et de l'initiation à l'informatique (y compris l'éducation des adultes) au début de l'essor de l'informatique personnelle jusqu'à aujourd'hui. L'objectif est de mettre sur un pied d'égalité le développement et l'utilisation de l'IA publicitaire, qu'elle soit bonne ou mauvaise.

sécurité

- Protections contre la singularité de la forme : Lignes directrices et protections pour la fusion de l'IA (comme le ChatGPT, l'IA vocale, l'IA de reconnaissance d'images, etc.) avec le matériel réel en une seule forme, similaire aux robots industriels ou aux robots humanoïdes du futur. En fin de compte, une telle capacité donne à l'intelligence générale des capacités d'interaction physique dans le monde physique. En fait, il s'agit de s'assurer qu'un robot physique de type ChatGPT ne se retourne jamais contre les humains ou ne présente pas de dysfonctionnement catastrophique. Il y a déjà eu plusieurs cas où des robots industriels et des voitures autonomes ont mal fonctionné et ont causé des dommages ou la mort d'êtres humains.

- Risques liés à l'IA : protection contre les risques posés par l'IA. ChatGPT a déjà fait l'objet d'une utilisation malveillante. Ce domaine prendra en compte des menaces telles que l'évolution des charges utiles malveillantes, la découverte et l'exploitation de vulnérabilités à une vitesse record, la fraude vocale et par hameçonnage, et le sabotage, comme la compromission des processus de fabrication ou les attaques de la chaîne d'approvisionnement.

- Risque pour l'IA : protections contre les risques posés à l'IA elle-même. Cela comprend l'exploitation du développement de l'IA, des processus d'apprentissage et des paramètres de biais. Bien qu'il existe des lignes directrices en matière d'éthique, de sécurité et d'utilisation du développement de l'IA, elles doivent être améliorées et compléter les pratiques de sécurité actuelles telles que le codage sécurisé, DevSecOps et SBOMS dans la chaîne d'approvisionnement. En ce qui concerne la consommation, nous disposons de politiques telles que la loi sur l'utilisation abusive des ordinateurs, les politiques de sécurité de l'entreprise en matière d'utilisation des ordinateurs et les politiques d'utilisation équitable.

Éthique et droit

- Éthique civique de l'IA : Éthique et lignes directrices sur l'utilisation de l'IA dans des domaines tels que la reconnaissance faciale et le comportement des utilisateurs contre la surveillance des employés, le contrôle et l'application des règles de circulation, et le système de justice pénale.

- Éthique scientifique de l'IA : Éthique et lignes directrices sur ce que l'IA peut faire en termes de science et de médecine. Les exemples sont la recherche génétique et la recherche sur les maladies, le clonage, etc.

- Éthique militaire de l'IA : Élaborer un ensemble de règles d'engagement de type convention de Genève pour l'utilisation de l'IA dans les opérations cinétiques, en particulier dans l'IA autonome. Cela serait particulièrement important pour les IA qui prennent des décisions de vie ou de mort afin de prévenir la possibilité de conséquences involontaires telles que des massacres, l'utilisation d'armes chimiques ou une détonation nucléaire involontaire.

- Cadre juridique de l'IA : Lignes directrices et normes relatives aux implications juridiques de l'implication de l'IA dans diverses situations juridiquement pertinentes. Il peut s'agir de scénarios tels que la nature des preuves admissibles dans les affaires juridiques ou les réclamations en matière d'assurance et de finance, ainsi que les calculs d'acceptation des risques.

Un cadre de sûreté et de sécurité de l'IA n'est qu'un début

Il est encourageant de constater que l'accent est mis sur le risque de cybermenaces liées à l'IA à l'échelle mondiale. Un cadre de sécurité de l'IA est une première étape essentielle pour construire un avenir innovant et sûr en matière d'IA. Mais ce n'est qu'un point de départ. Idéalement, il devrait y avoir une sélection de groupes d'élite, ciblés, d'experts en IA et de l'industrie qui s'associent pour développer et faire évoluer les normes de sécurité de l'IA, à l'instar de l'IETF (Internet Engineering Task Force) et des RFC (Request for Comments).

Il est important de réfléchir à la manière dont nous pouvons donner aux organisations les moyens de renforcer leur résilience face aux attaques menées par l'IA. L'IA permet aux criminels de lancer des attaques plus facilement et plus rapidement. La meilleure défense consiste à réduire la "surface d'apprentissage" afin que les cybermenaces IA aient moins de possibilités d'apprendre, de s'adapter et de faire progresser l'attaque.

Contactez-nous dès aujourd'hui pour savoir comment les développements de l'IA peuvent avoir un impact sur la cybersécurité de votre organisation.

.png)

.webp)

_(2).webp)

.webp)

.webp)