AIの安全性とセキュリティのためのセキュリティ実務者のフレームワーク

11月初旬、英国は人工知能に関する史上初の世界サミットである AI安全サミットを開催した。国際政府とAI専門家が集まり、AIのリスクと、国際的に調整された取り組みがリスクの軽減にどのように役立つかを検討しました。このサミットは、 AIの安全、安心、信頼できる開発と使用に関する最近の米国大統領令を含む、AIの安全性をめぐる世界的な議論に続くものです。

サミットからAIの安全性に関する具体的な枠組みやガイドラインが出てくることを期待していましたが、具体的なガイダンスが見つからずがっかりしました。このブログ投稿では、上級セキュリティ実務家としての私の視点から、サミットから期待していたAIの安全性に関する実用的なフレームワークの種類を概説しました。

AI の新しさを活用して、安全とセキュリティに対処

フレームワークを説明する前に、哲学的に一歩下がって、なぜ AI の安全性がこれほど重要なトピックなのか、そしてなぜ今年の AI 安全サミットの結果にこれほど失望したのかを理解することが重要だと思います。

現在私たちが使用している現在のネットワーク技術におけるセキュリティ上の欠陥のほとんどは、最終的には、それらが依存するプロトコルが数十年前に最初に設計されていた方法の弱点にまでさかのぼることができることは明らかです。

セキュリティは当初の考慮事項ではありませんでした。実際には、そうなることはめったにありません。

たとえば、Web(HTTP)、メール(SMTP)、ファイル転送(FTP)の元のプロトコルを考えてみましょう。これらはすべて、暗号化によるデータセキュリティを一切行わずにプレーンテキストとして設計されました。当時のクリエイターは、銀行、臨床患者情報、または機密性の高いユーザー情報がすべて、これらの単純なネットワークプロトコルを介して世界中に自由かつ便利に送信される世界を想定していませんでした。

同じことが、IETF(Internet Engineering Task Force)の出版物 RFC 791で説明されている1980年代初頭に作成されたIPv4アドレス指定スキームにも当てはまります。当時、世界が現実的に何十億ものパブリックアドレス可能なIPアドレスを使い果たす可能性があるとは誰が想像したでしょうか?それでも、セキュリティを遡及的に強化しようとすることは、通常、ボトルネックであり、破壊的な取り組みであることが判明します。

今月一般公開開始 1 周年 を迎える OpenAI の ChatGPT などの生成 AI は、機械学習とディープラーニング機能の進歩を示しました。このタイプの大規模言語モデル (LLM) は、人工ニューラル ネットワーク (ANN) を介して人間の脳のニューラル ネットワークをほぼ模倣できます。世界は初めて、AI が ChatGPT などの製品ですぐに使用できるようになるようになるという、長年にわたるさまざまな取り組みの集大成を目の当たりにしました。突然、汎用人工知能 (AGI) と理論的にはるかに優れた人工超知能 (ASI) の可能性さえも、もはやフィクションの誇張ではないかもしれません。

AIが進化の初期段階にあるという事実を利用して、特にネットワーキングとセキュリティの歴史と重荷を考慮して、その 安全性とセキュリティを考慮する必要があります。 2023 年 11 月のような AI 安全サミットは、懸念に対処するだけでなく、一歩下がって AI の安全性とセキュリティを全体的な視点で評価すべきでした。残念ながら、これが達成されたかどうかはわかりません。少なくともその時はそうではありません。

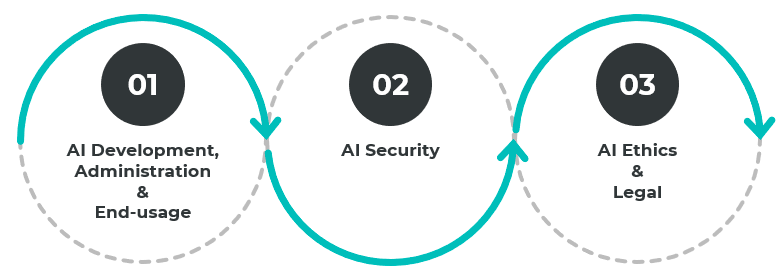

AIの安全・安心の3つの主要領域

AIの安全性とセキュリティに関する世界初の積極的な国際サミットでは、次の主要な領域に対処するために、地政学から地政学への具体的な移行を期待しました。

- 開発、管理、および最終用途

- セキュリティ

- 倫理と法則

これらのドメインは絡み合っているため、互いに関連しています。たとえば、AI ソリューションの開発には、トレーニング データのバイアスや深層学習システムの隠れ層構成などのソースの問題を抑制するために、倫理と法的領域を網羅する必要があります。うまくいくことすべてが正しいことではありません。同時に、トレーニング データと開発プロセスの整合性を確保することも、プロセスのできるだけ早い段階で含める必要があります。

AI 安全フレームワーク: AI 安全サミットに期待したこと

3つの領域のそれぞれの下で、私はさらに検討すべき主要な基準とフレームワークの選択を提案し、その最終結果は、これらの基準とフレームワークの策定を目的としたフォーカスグループを開始することです。

開発、管理、および最終用途

- インターフェース標準とフレームワーク: 物理デバイス用の JSON と USB-C を使用した Web API と同様に、異なるベンダー間、およびベンダーとエンド ユーザー間の AI のインターフェースに関するガイドラインと標準。これにより、複数のドメインにわたるイノベーションをさらに迅速に行うことができます。この良い例は、Wi-Fi とモバイル通信のインターフェースがスマートウォッチ、テレビ、ドローン、自動車、救急車などの技術革新にもたらしたことです。

- 差別化基準とフレームワーク: オリジナルの芸術作品と、デジタル著作権管理(DRM)の著作権と知的財産保護のためのAI生成作品との間の明確な決定と区別を可能にするポリシー。重要な受益者の分野の 1 つは、少なくとも商品レベルで、ディープフェイクや選挙干渉などの誤った情報や欺瞞的なコンテンツに取り組むことです。

- AIスキルのギャップ: パーソナルコンピューティングの初期ブームから今日までのコンピュータープログラミングとコンピューターリテラシー(成人教育を含む)の取り組みと同様に、AI開発、AI管理、およびAI使用の主要分野におけるスキルギャップに対処します。これは、良い AI と悪い広告 AI の両方の開発と使用のための競争の場を平等にすることを目的としています。

セキュリティ

- フォーム保護の特異点: AI (ChatGPT、音声 AI、画像認識 AI など) を実際のハードウェアと統合して、将来の産業用ロボットやヒューマノイド ロボットと同様に 1 つの形式にするためのガイドラインと保護。このような機能は、最終的に一般的な知能AIに物理世界での物理的相互作用機能を与えます。基本的には、ChatGPTタイプの物理ロボットが人間の電源を入れたり、壊滅的な誤動作を起こしたりしないようにすることです。産業用ロボットや自動運転車が誤動作し、人間に危害や死亡をもたらすという出来事はすでに多様です。

- AI による リスク: AI によってもたらされるリスクに対する保護。ChatGPTはすでに悪意のある使用を示しています。この領域では、進化する悪意のあるペイロード、記録的なスピードの脆弱性の発見と悪用、音声詐欺やフィッシング詐欺、製造プロセスの侵害やサプライチェーン攻撃などの妨害行為などの脅威が考慮されます。

- AI に対する リスク: AI 自体にもたらされるリスクに対する保護。これには、AI 開発、学習プロセス、バイアス パラメーターの活用が含まれます。AI開発倫理、セキュリティ、使用ガイドラインは存在しますが、サプライチェーンにおける安全なコーディング、DevSecOps、SBOMSなどの現在のセキュリティ慣行を改善し、改善する必要があります。消費面では、コンピュータ不正使用法、コンピュータ使用に関する企業セキュリティポリシー、公正使用ポリシーなどのポリシーがあります。

倫理と法務

- AI市民倫理: 従業員の監視、交通規制と執行、刑事司法制度に対する顔認識やユーザーの行動などの分野で AI を使用する際の倫理とガイドライン。

- AI科学倫理: 科学と医学の観点から AI を使用して何ができるかに関する倫理とガイドライン。例としては、遺伝学や病気の研究、クローニングなどがあります。

- AI軍事倫理: 運動運用、特に自律型 AI で AI を使用するためのジュネーブ条約型の一連の交戦規則を作成します。これは、大量殺戮、化学兵器の使用、意図しない核爆発などの意図しない結果の可能性を防ぐために、AI が生死に関わる決断を下す場合に特に重要です。

- AI の法的枠組み: 法的に関連するさまざまな状況に AI を関与させることの法的影響に関するガイドラインと基準。これには、訴訟における許容可能な証拠の性質、保険および財務請求、リスク受け入れの計算などのシナリオが含まれる場合があります。

AI の安全性とセキュリティのフレームワークは始まりにすぎません

世界規模で AI サイバー脅威のリスクに重点が置かれているのは心強いことです。AI 安全フレームワークは、革新的でありながら安全な AI の未来を構築するための重要な第一歩です。しかし、これは出発点にすぎません。理想的には、インターネット エンジニアリング タスク フォース (IETF) やコメント依頼 (RFC) と同様の AI 安全標準の開発と反復のために提携する、AI および業界の対象分野の専門家からなるエリートで焦点を絞ったグループが選ばれる必要があります。

重要なのは、組織がAIを活用した攻撃に対する レジリエンスを構築 できるようにする方法も検討する必要があることです。AI により、犯罪者が攻撃を開始することがより簡単かつ迅速になります。最善の防御策は、「学習対象領域」を縮小して、AI サイバー脅威が学習し、適応し、攻撃を進行させる機会を減らすことです。

AI の発展が組織のサイバーセキュリティにどのような影響を与えるかについては、今すぐお問い合わせください。

.png)

.webp)

_(2).webp)

.webp)

.webp)