Marco de un profesional de la seguridad para la seguridad de la IA

A principios de noviembre, el Reino Unido organizó la Cumbre de Seguridad de la IA, la primera cumbre mundial sobre inteligencia artificial. Reunió a gobiernos internacionales y expertos en IA para considerar los riesgos de la IA y cómo los esfuerzos coordinados internacionalmente pueden ayudar a mitigarlos. Esta cumbre sigue a las discusiones globales sobre la seguridad de la IA, incluida la reciente Orden Ejecutiva de EE. UU. sobre el Desarrollo y Uso Seguro y Confiable de la IA.

Esperaba ver un marco específico o pautas para la seguridad de la IA en la cumbre, pero me decepcionó no encontrar una guía tangible. En esta publicación de blog, describí el tipo de marco procesable sobre la seguridad de la IA que esperaba ver salir de la cumbre desde mi perspectiva como profesional senior de seguridad.

Aproveche la novedad de la IA para abordar la seguridad y la protección

Antes de exponer el marco, creo que es importante dar un paso filosófico para comprender por qué la seguridad de la IA es un tema tan importante y por qué me decepcionaron tanto los resultados de la Cumbre de Seguridad de la IA de este año.

Es bastante evidente que la mayoría de las deficiencias de seguridad en las tecnologías de red actuales que usamos hoy en día se remontan en última instancia a las debilidades en la forma en que los protocolos de los que dependen se diseñaron originalmente hace décadas.

La seguridad no fue una consideración inicial. En realidad, rara vez lo es.

Tomemos, por ejemplo, los protocolos originales para sitio web (HTTP), correo (SMTP) y transferencia de archivos (FTP). Todos estos fueron diseñados como texto sin formato sin ningún tipo de seguridad de datos a través del cifrado. Los creadores en ese momento no imaginaron un mundo en el que la banca, la información clínica de los pacientes o la información confidencial de los usuarios se transmitieran libre y convenientemente a través de estos simples protocolos de red.

Lo mismo ocurre con el esquema de direccionamiento IPv4 creado a principios de la década de 1980 descrito en la publicación RFC 791 del IETF (Internet Engineering Task Force). ¿Quién pensó en ese momento que el mundo podría quedar sin miles de millones de direcciones IP con direcciones públicas? Aun así, tratar de atornillar retrospectivamente la seguridad generalmente resulta ser tanto un cuello de botella como una compañía disruptiva.

La IA generativa como ChatGPT de OpenAI, que celebra su primer aniversario de disponibilidad pública este mes, mostró los avances en el aprendizaje automático y las capacidades de aprendizaje profundo. Este tipo de modelo de lenguaje grande (LLM) puede imitar en gran medida las redes neuronales del cerebro humano a través de redes neuronales artificiales (ANN). Por primera vez, el mundo fue testigo de la culminación de varios cuerpos de trabajo a lo largo de los años para que la IA se vuelva fácilmente utilizable en ofertas como ChatGPT. De repente, incluso la posibilidad de la Inteligencia General Artificial (AGI) y la Súper Inteligencia Artificial (ASI) teóricamente muy superior puede que ya no sea una exageración de los títulos de ficción.

Debemos aprovechar el hecho de que la IA aún está lo suficientemente temprano en su evolución como para considerar su seguridad y protección, especialmente con la historia y el bagaje de las redes y la seguridad. Una cumbre de seguridad de IA como la de noviembre de 2023 no solo debería abordar los temores, sino también dar atrás para evaluar la seguridad de la IA con una visión holística. Desafortunadamente, no estoy seguro de que esto se logró; al menos no esa vez.

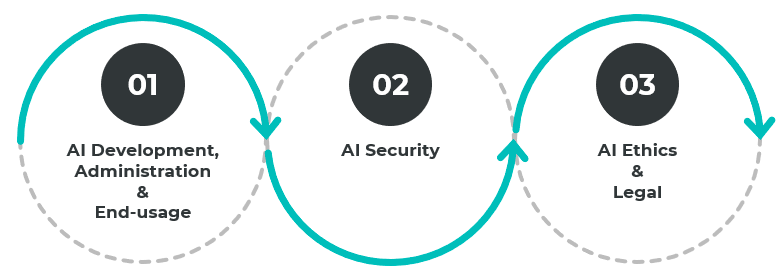

3 dominios principales para la seguridad de la IA

Para la primera cumbre internacional proactiva de su tipo sobre seguridad y protección de la IA, esperaba un movimiento tangible de la geopolítica a las geopolíticas para abordar los siguientes dominios principales:

- Desarrollo, administración y uso final

- seguridad

- Ética y legal

Estos dominios están entrelazados y, por lo tanto, relacionados entre sí. Por ejemplo, el desarrollo de soluciones de IA debe abarcar los dominios éticos y legales para frenar problemas de origen como el sesgo en los datos de entrenamiento y la configuración de capas ocultas de los sistemas de aprendizaje profundo. No todo lo que funciona es lo correcto. Al mismo tiempo, la garantía de la integridad de los datos de entrenamiento y el proceso de desarrollo debe incluir lo antes posible en el proceso.

Un marco de seguridad de IA: lo que esperaba ver de la Cumbre de Seguridad de IA

En cada uno de los tres dominios, sugerí una selección de estándares y marcos clave que se considerarán más a fondo, cuyo resultado final debería ser iniciar grupos focalizados destinados a formular estos estándares y marcos:

Desarrollo, administración y uso final

- Normas y marco de interfaz: Directrices y estándares sobre la interfaz de IA entre diferentes proveedores y luego entre proveedores y usuarios finales, similar a la API sitio web con JSON y USB-C para dispositivos físicos. Esto puede permitir una innovación aún más rápida en múltiples dominios. Un buen ejemplo de esto es lo que la interfaz de comunicación móvil y Wi-Fi hizo por la innovación tecnológica en relojes inteligentes, televisores, drones, automóvil, ambulancias, etc.

- Estándares y marco de diferenciación: Políticas que permitan la determinación y diferenciación claras entre las obras artísticas originales y las obras generadas por IA, como las que tenemos para la gestión de derechos digitales (DRM), los derechos de autor y las protecciones de la propiedad intelectual. Un área de beneficio importante será abordar la desinformación y el contenido engañoso, como las falsificaciones profundas y la interferencia electoral, al menos a nivel de productos básicos.

- Brecha de habilidades de IA: Abordar la brecha de habilidades en las áreas clave del desarrollo de la IA, la administración de la IA y el uso de la IA, similar a los esfuerzos en programación informática y alfabetización informática (incluida la educación de adultos) en el auge inicial de la computación personal hasta hoy. Esto tiene como objetivo nivelar el campo de juego tanto para el desarrollo y uso de IA buena como para la mala.

seguridad

- Singularidad de las protecciones de forma: Pautas y protecciones para fusionar IA (como ChatGPT, IA de voz, IA de reconocimiento de imágenes, etc.) con hardware real en una sola forma, similar a robots industriales o robots humanoides en el futuro. Tal capacidad finalmente le da a la inteligencia general capacidades de interacción física de IA en el mundo físico. Básicamente, cerciorar de que un robot físico tipo ChatGPT nunca se vuelva contra humanos o funcione mal de manera catastrófica. Ya hay varios casos en los que los robots industriales y los automóvil autónomos funcionaron mal y causaron daños o la muerte a los humanos.

- Riesgo de la IA: Protecciones contra los riesgos que plantea la IA. ChatGPT ya mostró un uso malicioso. Esta área considerará amenazas como la evolución de cargas útiles maliciosas, el descubrimiento y la explotación de vulnerabilidades a una velocidad récord, el fraude de voz y phishing, y el sabotaje como el compromiso de los procesos de fabricación o los ataques a la cadena de suministro.

- Riesgo para la IA: Protecciones contra los riesgos que plantea la propia IA. Esto incluye la explotación del desarrollo de IA, los procesos de aprendizaje y los parámetros de sesgo. Si bien existen pautas de ética, seguridad y uso de desarrollo de IA, deben mejorar y mejorar las prácticas de seguridad actuales, como la codificación segura, DevSecOps y SBOMS en la cadena de suministro. Aparte del lado del consumo, tenemos políticas similares a la ley de uso indebido de computadoras, políticas de seguridad de la compañía sobre el uso de computadoras y políticas de uso justo.

Ética y Legal

- Ética cívica de la IA: Ética y pautas sobre el uso de IA en esferas como el reconocimiento facial y el comportamiento del usuario contra el monitoreo de empleados, el control y la aplicación del tráfico y el sistema de justicia penal.

- Ética científica de la IA: Ética y directrices sobre lo que se puede emplear la IA en términos de ciencia y medicina. Ejemplos de investigación genética y de enfermedades, clonación, etc.

- Ética militar de la IA: Desarrollar un conjunto de reglas de enfrentamiento tipo Convención de Ginebra para usar IA en operaciones cinéticas, especialmente en IA autónoma. Esto sería particularmente importante para que la IA tome decisiones de vida o muerte para evitar la posibilidad de consecuencias no deseadas, como asesinatos en masa, uso de armas químicas o una detonación nuclear no deseada.

- Marco legal de IA: Directrices y estándares en torno a las participaciones legales de involucrar a la IA en diversas situaciones legalmente relevantes. Esto podría incluir escenarios como la naturaleza de las pruebas admisibles en casos legales o reclamaciones de seguros y finanzas y cálculos de aceptación de riesgos.

Un marco de seguridad y protección de IA es solo el comienzo

Es alentador ver un fuerte enfoque en el riesgo de las amenazas cibernéticas de IA a escala global. Un marco de seguridad de IA es un primer paso esencial para construir un futuro de IA innovador pero seguro. Pero esto es solo un punto de partida. Idealmente, debería haber una selección de grupos de élite enfocados en IA y expertos en la materia de la industria que se asocien para desarrollar e iterar estándares de seguridad de IA similares al Grupo de Trabajo de Ingeniería de Internet (IETF) y la Solicitud de Comentarios (RFC).

Es importante destacar que también debemos considerar cómo podemos capacitar a las organizaciones para desarrollar resiliencia contra los ataques impulsados por IA. La IA hace que sea más fácil y rápido para los delincuentes lanzar ataques. La mejor defensa es reducir la "superficie de aprendizaje" para que haya menos oportunidades para que las amenazas cibernéticas de IA aprendan, se adapten y progresen en el ataque.

Contáctenos hoy para saber cómo los desarrollos en IA pueden afectar la ciberseguridad de su organización.

.png)

.webp)

_(2).webp)

.webp)

.webp)